Dans les paragraphes qui suivent ne sont exposés que les grandes généralités et les principes fondamentaux de la photogrammétrie. Une information plus détaillée sur les étapes de calcul de la photogrammétrie aérienne et numérique est présentée en annexe 2 (non intégrée sur le site).

3.1. Généralités

3.1.1. Historique

La photogrammétrie peut se définir comme étant la science, l’ensemble des méthodes et techniques permettant de définir la forme et la position d’objets à partir de photographies de ceux-ci.

C’est en 1859 que le colonel français A. Laussedat présenta à l’Académie des Sciences, une méthode de détermination de coordonnées de points basée sur un calcul d’intersection spatiale à partir d’un couple de clichés de l’objet. Parallèlement, l’architecte allemand A. Meydenbauer, à qui l’on doit le terme de photogrammétrie, utilise avec succès ces techniques dans des travaux architecturaux de grande envergure.

De nombreux progrès techniques et théoriques ont permis, dès le début du 20ème siècle, à cette science nouvelle d’évoluer rapidement : la stéréophotogrammétrie développée par C. Pulfrich (1901), la définition de principes pour une mise en œuvre rationnelle des restituteurs optico-mécaniques par O. von Gruber…

Actuellement, le développement des moyens de calculs est tel, qu’ils permettent de traiter toujours plus de données, avec des algorithmes toujours plus complets.

3.1.2. Les grands principes de la photogrammétrie

La photogrammétrie exploite la faculté de l’homme à percevoir le relief à partir de deux images planes d’un objet, prises de deux points de vue différents. C’est ce que nous faisons quotidiennement grâce à nos yeux et leurs rétines.

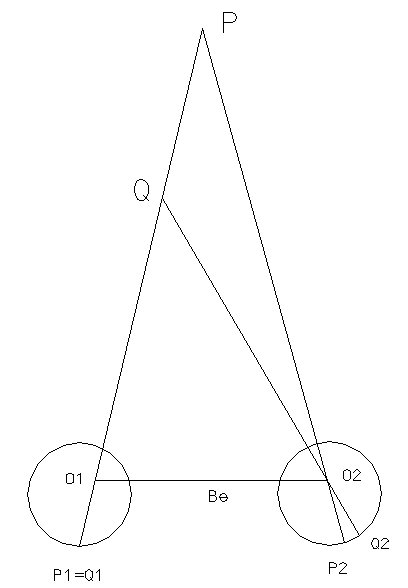

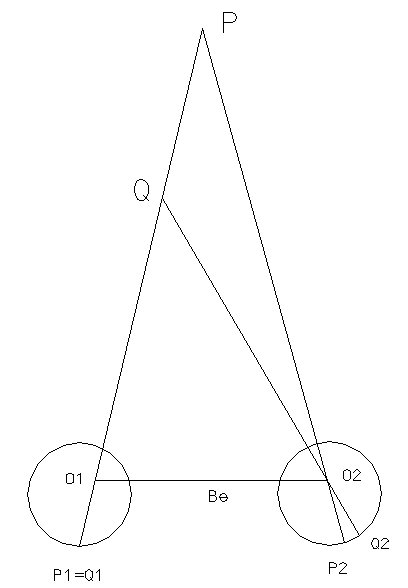

Comme le montre la figure (fig. 3.1), les points P et Q de l’espace objet sont à des éloignements différents du point d’observation. Il en résulte une parallaxe horizontale (P2Q2), qui différencie les deux images rétiniennes lors du fusionnement. Il est intéressant de noter que l’acuité en vision binoculaire est de l’ordre de 5’’ à 10’’, soit 6 à 12µm pour une distance de mise au point de 25cm, alors qu’elle n’est que de 30’’ en vision monoculaire, soit 40µm pour la distance de mise au point.

(fig. 3.1) Principe de la vision binoculaire,

plan d’observation horizontal (Kraus, 1998)

A partir de deux clichés, on peut reconstituer le même processus. La détermination de l’objet est alors basée sur la mesure des coordonnées, dans l’espace image, de la trace que cet objet a laissé sur l’émulsion photographique. L’élément fondamental de cette mesure est la parallaxe horizontale (fig. 3.2), à partir de laquelle peut être calculé la distance à l’objet (voir §3.1.3).

Au final, les coordonnées tridimensionnelles de l’objet, dans un système de référence qui lui est propre, sont issues d’une transformation spatiale, dite projective ou de similitude.

3.1.3. La mesure photogrammétrique

Cette opération porte le nom de stéréorestitution, et nécessite des calculs préalables, le premier étant l’orientation interne. Cette étape permet de définir le référentiel des mesures effectuées sur un cliché. Elle est réalisée grâce aux repères de fond de chambre (fig. 4.2), lorsqu’ils existent.

Enfin, l’orientation externe permet de se rapporter à l’objet. Cette orientation peut être faite en une étape, en établissant un lien direct entre les mesures sur le cliché et le système de référence de l’objet, ou en deux étapes, soit une orientation relative, qui crée un modèle plastique permettant l’observation stéréoscopique, puis une orientation absolue qui projette ce stéréomodèle sur le système objet, par le biais d’une similitude spatiale.

Plus concrètement, la mesure photogrammétrique consiste, après élimination de la parallaxe verticale, à déterminer la parallaxe horizontale, dans les référentiels image de chacun des clichés. La parallaxe verticale est éliminée lors de l’orientation relative du couple. On satisfait alors la condition de coplanéité, fondamentale pour autoriser toute mesure ultérieure.

(fig. 3.2) Parallaxe horizontale sur un couple de clichés

(fig. 3.2) Parallaxe horizontale sur un couple de clichés

Dans un cadre général, on pourra alors déterminer les coordonnées modèle de tout point, pour ensuite les projeter dans le système terrain ou objet. Les relations permettent le passage des coordonnées image aux coordonnées terrain, dans le cas normal, c’est à dire seulement lorsque les prises de vue sont verticales.

dans ces relations apparaissent B la base, ou distance entre les deux prises de vue, et c, la distance principale de la chambre photographique employée.

3.2. Photogrammétrie numérique

L’évolution actuelle des moyens de calcul informatique est telle que l’emploi de la photogrammétrie numérique est devenue très abordable, par le biais de nombreux logiciels de traitement fonctionnant sur PC et plates-formes classiques.

3.2.1 Définition de l’image numérique

Une image numérique est une matrice bidimensionnelle de valeurs, numériques, de niveaux de gris, correspondant aux valeurs radiométriques issues de l’objet. Chaque élément de l’image, ou pixel (picture element) porte donc une information, étalée sur une palette allant de 0 à 255 pour les images codées sur 8 bits, ce qui est le cas le plus courant.

Dans le cas de photographies numérisées, il est alors important de connaître la résolution de scannage, car elle sera nécessairement moins bonne que la résolution initiale du cliché, tant au sens spatial que radiométrique du terme. Une telle constatation impose de considérer certaines limitations dans l’emploi des images numériques dans le cadre de traitements photogrammétriques poussés.

A cette image numérique, on associe un référentiel dont l’axe x est orienté vers la droite et l’axe y vers le bas, centré sur un point décalé d’un demi pixel en x et y du coin supérieur gauche de la matrice. On référence alors les coordonnées des centres de chaque pixel.

Dès lors, un grand nombre de traitements sont possibles pour améliorer les qualités d’image, automatiser les processus de mesures ou les extractions des données.

3.2.2. Images épipolaires ou normales

Les images normales sont capitales pour rendre possible l’application des méthodes de mise en relation automatique des pixels. Ainsi, la vision par ordinateur s’apparente à la vision humaine, puisqu’elle va en reproduire le processus.

Le calcul d’images normales, à partir de prises de vues quelconques, suppose une orientation relative par rotation des clichés préalable. Le calcul consiste alors à déterminer la nouvelle matrice image de l’image normale, en veillant à le paramétrer de telle sorte que toute perte de pixels soit proscrite. Les relations entre pixels de chaque image et les méthodes de rééchantillonnage, présentées plus bas, permettent une réattribution des valeurs radiométriques dans l’image normale.

3.2.3. Corrélation d’image

Le traitement numérique des données photographiques pour la photogrammétrie permet d’utiliser des algorithmes de recherche automatique de points homologues par corrélation sur les clichés d’un couple, basées sur les techniques d’analyse d’image et de traitement du signal.

Mathématiquement, on peut considérer que la valeur de gris d’un pixel, d’une image numérique, est exprimable sous la forme d’une fonction de deux variables, à valeurs discrètes. Dans un couple, chaque image aura alors une fonction de ce type, et la corrélation entre les deux s’exprimera sous la forme d’une somme finie.

où f* est le complexe conjugué. L’étude des variations de cette fonction permet de déterminer le maximum de corrélation, avec une taille (M,N) fixée de matrice de pixels, pour une position (x,y) dans l’image (Gonzalez et Woods, 1993).

De façon plus générale et pragmatique, la quasi totalité de ce type d’algorithmes travaillent avec une matrice de pixels, de taille variable, centrée sur un pixel. Les éléments de la matrice sont les valeurs de niveaux de gris des pixels avoisinant le pointé.

L’algorithme utilisé par PHOTOMOD (Manuel de l’utilisateur), logiciel employé pour la réalisation du projet, utilise une matrice, ou fenêtre, de corrélation, dont la taille est fixée par l’utilisateur. Pour trouver l’homologue d’un point saisi sur l’image de gauche, le logiciel applique un filtre de moyenne afin de réduire le bruit. La fenêtre est alors déplacée jusqu’à obtenir un maximum de corrélation. A partir de la position déterminée, le logiciel recalcule le point à une précision sous pixellaire.

En conclusion, un point homologue n’est validé que si le coefficient de corrélation est supérieur au seuil minimum fixé.

où les I sont les valeurs de niveau de gris des pixels, Imoy est une moyenne des valeurs de niveaux de gris à l’intérieur de la matrice de corrélation. Le coefficient ainsi défini est situé dans l’intervalle [-1,1].

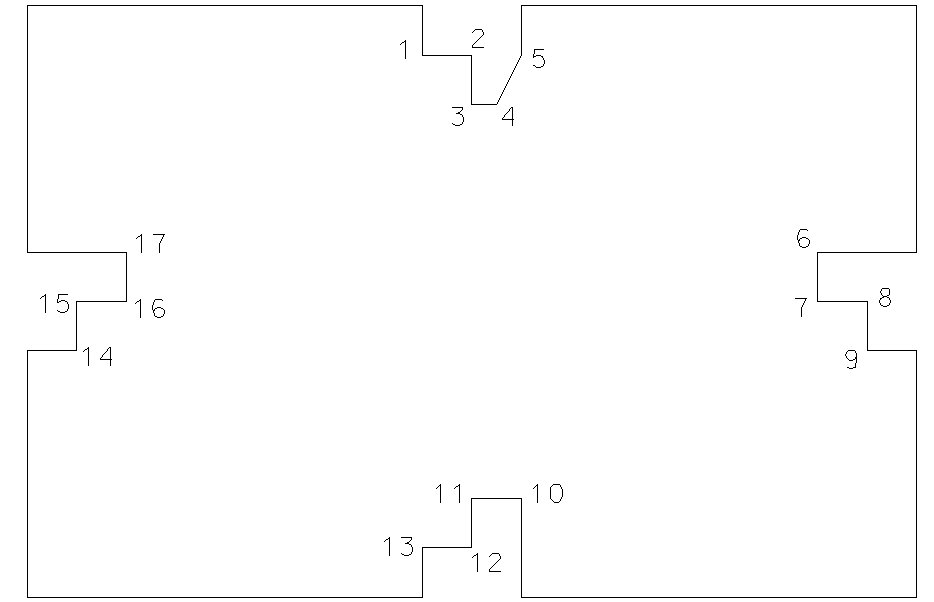

3.2.4. Images numériques rééchantillonnées

Pour effectuer une correction géométrique de l'image originale, on applique un procédé appelé rééchantillonnage afin de déterminer la valeur numérique à placer dans la nouvelle localisation du pixel de l'image de sortie corrigée. Le processus de rééchantillonnage calcule la nouvelle valeur du pixel à partir de sa valeur originale dans l'image non corrigée. Il existe trois principales méthodes de rééchantillonnage : le plus proche voisin, l'interpolation bilinéaire et la convolution cubique.

La méthode du plus proche voisin (fig. 3.3) utilise la valeur numérique du pixel de l'image originale qui se trouve le plus près de la localisation du nouveau pixel dans l'image corrigée. C'est la méthode la plus simple et elle n'altère pas la valeur originale, mais elle peut produire une duplication des pixels ou une perte de certaines valeurs. Cette méthode a aussi tendance à produire des images bruitées.

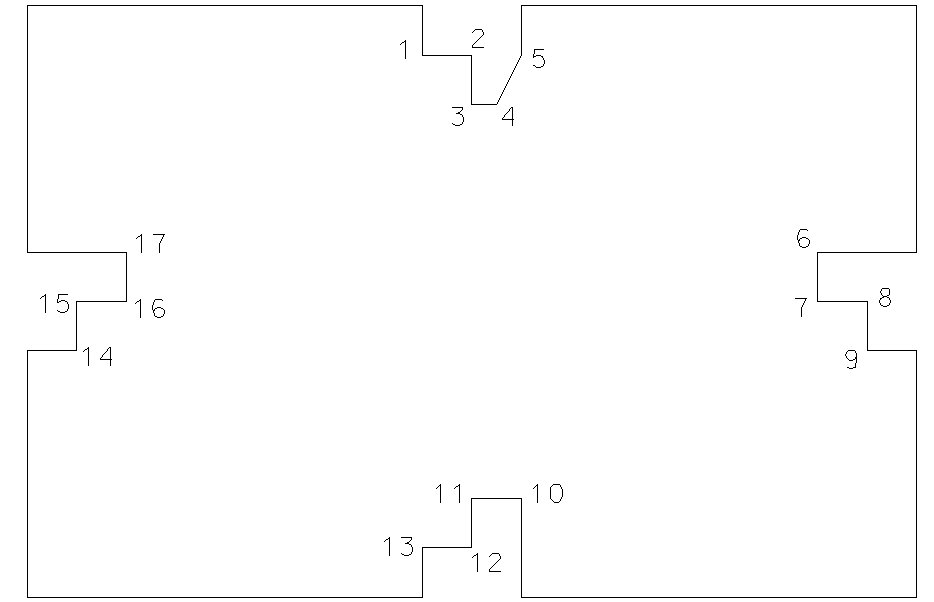

(fig. 3.3) Méthode du plus proche voisin

(fig. 3.3) Méthode du plus proche voisin

L'interpolation bilinéaire (fig. 3.4) prend une moyenne pondérée par la distance des quatre pixels de l'image originale les plus près du nouveau pixel. Le procédé de moyenne altère la valeur originale des pixels et crée une valeur complètement nouvelle sur l'image finale.

(fig. 3.4) Interpolation bilinéaire

(fig. 3.4) Interpolation bilinéaire

Le processus de convolution cubique (fig. 3.5) va encore plus loin et calcule la moyenne pondérée par la distance sur un bloc de seize pixels à partir de l'image originale entourant la localisation du nouveau pixel de sortie. Comme pour l'interpolation bilinéaire, cette méthode résulte en de nouvelles valeurs de pixels. Cependant, ces deux méthodes produisent des images à l'apparence plus douce, contrairement à la méthode du plus proche voisin (CCRS, 1998).

(fig. 3.5) Convolution cubique

(fig. 3.5) Convolution cubique

3.2.5. Orthophotographies et orthophotoplans

Actuellement, on constate un effort de développement considérable des orthophotos et des orthophotoplans. La richesse d’information qu’ils présentent, comparé à une cartographie vectorielle, est en fait leur atout principal (Revue Géomètre, 1999).

Les différentes méthodes de réalisation n’emploient qu’un seul cliché de l’objet. Or, sachant qu’il est impossible de restituer la forme d’un objet sans un couple, il est nécessaire de disposer d’une information supplémentaire telle qu’un modèle numérique de terrain.

L’obtention d’une orthophotographie se fait à partir des clichés originaux, corrigés du point de vue géométrique. En appliquant des surcharges graphiques, des données vecteur on obtient l’orthophotoplan.

Concernant la qualité de ce type de travaux, il est nécessaire de disposer de clichés de qualité photographique élevée. Toute imprécision se ressent inévitablement sur la qualité du produit final.

Pratiquement, la création d’une orthophoto numérique

3.3. La triangulation photogrammétrique ou aérotriangulation

3.3.1. Définition de l’aérotriangulation

Les principes de base de la stéréorestitution font apparaître que pour travailler sur un stéréomodèle, il faut disposer d’au moins trois points de calage, déterminés par des méthodes géodésiques (tachéométrie, GPS…)

L’aérotriangulation est une extension des méthodes de stéréorestitution, qui permet de restituer de façon globale un bloc de clichés tout en minimisant le nombre de points de calage à déterminer sur le terrain. On peut donc survoler des zones possédant une faible densité de points géodésiques.

3.3.2.Exigences de l’aérotriangulation

Les résultats finaux peuvent alors provenir de deux méthodes de calcul différentes. On dispose tout d’abord d’une méthode de compensation en bloc par modèles indépendants. Celle ci se base sur une transformation de similitude spatiale appliquée à des coordonnées modèle.

Usuellement, cette méthode est employée avec des prises de vues réalisées avec des chambres métriques, et nécessite la détermination des stéréomodèles, afin d’en obtenir les coordonnées de points qui seront transformées dans le système de référence de l’objet. On doit donc effectuer l’orientation relative des clichés avant de s’intéresser à la transformation qui ramènera dans ce système.

Dans ce cas, la disposition des points de calage va avoir une importance considérable quant aux précisions tant planimétrique qu’altimétrique. Il est également à noter que ces deux paramètres n’ont pas d’influence réciproque dans un tel calcul.

La seconde méthode qui peut être employée est celle dite de compensation par les faisceaux. Celle-ci est développée ci-dessous.

D’après les recommandations de la Société Américaine de Photogrammétrie, il faut veiller à répartir les points de calage de façon suffisamment homogène, en vue d’atteindre une bonne précision, sachant que la solution la plus satisfaisante sera de les disposer dans les coins et sur les bords des bandes constituant le modèle. Le but essentiel est finalement d’éviter toute extrapolation.

De plus, il est recommandé de disposer de 4 à 5 points de calage sur le premier modèle afin de pouvoir effectuer le calcul de l’échelle et de l’orientation absolue avec une précision aussi élevée que possible (ASPRS, 1980). C’est en quelque sorte une condition sine qua non pour démarrer le calcul de l’aérotriangulation.

3.3.3. Préparation d’un vol photographique

Le plan de vol se détermine à partir des différents paramètres de vol, qui doivent être fixés à priori, et des caractéristiques de la chambre de prise de vues employée.

Les différentes relations employées pour la détermination des paramètres de vol sont les suivantes (Kraus, 1998) :

| Longueur de côté sur le terrain |  |

| Hauteur de vol au-dessus du sol |  |

| Recouvrement longitudinal |  |

| Recouvrement latéral |  |

| Longueur de base pour l fixé |  |

| Distance entre bandes pour q fixé |  |

| Intervalles de temps entre prises de vues |  |

Ces relations sont exprimées dans le cas habituel de la photographie aérienne, c’est à dire avec l’emploi d’un format d’image carré (23x23 cm2 généralement) et des axes de prise de vues verticaux.

3.3.4. Effet de filé

La préparation du vol suppose également de porter intérêt aux conditions d’utilisation de la chambre de prise de vues. En effet, pour effectuer les prises, on va employer une vitesse d’obturation pour une ouverture de diaphragme donnée. Cependant, il faut tenir compte du fait que l’avion se déplace, et que ce déplacement aura pour conséquence un filé sur le cliché, détériorant sa qualité.

Concrètement, l’effet de filé a la conséquence suivante : un point de l’objet ne donnera pas un point sur l’émulsion mais une traînée dont la longueur est fonction de la vitesse de déplacement et du rapport d’échelle, c'est à dire de la distance à l’objet et de la focale de l’objectif.

où v est la vitesse de l’avion, t le temps d’exposition et m

b le coefficient d’échelle. On obtient alors le filé théorique u

th, et on a empiriquement constaté qu’en fait, le filé effectif s’élève à 50% de cette valeur (Kraus, 1998).

Compte tenu de la vitesse de croisière de l’appareil, il convient de choisir un temps d’exposition de l’émulsion suffisamment court afin de limiter les effets de ce désagrément, en veillant à adapter l’ouverture du diaphragme.

3.4. Principes de compensation3.4.1. Méthode de compensation par les faisceauxDe façon synthétique, cette méthode repose sur l’utilisation des coordonnées images comme observations, et sur l’emploi d’une projection centrale.

Cette méthode de calcul permet de lier directement les coordonnées image aux coordonnées objet, sans passer par les coordonnées modèle. Elle nécessite un bloc de clichés présentant un recouvrement minimum de 60% en longitudinal, et de 20% en latéral.

D’autre part, cette méthode a un avantage considérable puisqu’elle autorise l’introduction dans le calcul de paramètres additionnels. On peut donc inclure dans le calcul les éléments d’orientations interne comme inconnues, mais aussi des paramètres de déformation de l’image, qui peut provenir non seulement des distorsions de l’objectif utilisé mais également des déformations du film, de diverses anomalies de réfraction ou de toute autre source d’erreur. Par conséquent, on tiendra compte des erreurs systématiques quelles que soient leurs origines. Ceci est particulièrement important dans le cas de l’utilisation d’une chambre de prises de vues amateur.

De fait, les qualités citées font de cette méthode la plus précise de l’aérotriangulation.

3.4.2. Calcul d’une compensation par les faisceauxOn peut donc faire intervenir un certain nombre de paramètres complémentaires afin d’affiner la détermination. Cependant, l’introduction d’inconnues supplémentaires dans le calcul demande donc que le nombre de points de calage connus soit suffisant. Les conditions de cette introduction sont développées dans la suite. Attachons-nous tout d’abord à l’explicitation de la méthode.

La matrice des coefficients des équations normales, puis la matrice N, est calculée à partir des relations de base de la photogrammétrie, qui expriment les coordonnées image en fonction des coordonnées objet, exprimé dans un système de référence choisi par l’utilisateur.

Ces relations font apparaître les paramètres ou variables suivants :

- xi, êta : coordonnées image d’un point

- (X,Y,Z) : coordonnées du point dans le système objet

- xi0, êta0: coordonnées image du point principal

- (X0,Y0,Z0) : coordonnées du centre de projection

- rij : coefficients de la matrice rotation

Ces équations sont ensuite linéarisées pour pouvoir leur appliquer le principe des moindres carrés.

La forme des équations normales permet de simplifier le calcul matriciel. En effet, le système des équations normales fait apparaître une matrice constituée de blocs, ou sous-matrices, bien distincts. De plus, certaines d’entre elles étant hyperdiagonales, l’inversion en est facilitée.

De façon générale, le système des équations normales s’exprime sous la forme de l’expression, mais dans le cas étudié, on peut développer son écriture et obtenir.

Les matrices N11 et N22 sont diagonales par blocs, l’une avec des blocs (6,6), l’autre avec des blocs (3,3). On peut alors éliminer un des deux vecteurs inconnus et déterminer l’autre assez simplement :

3.4.3. Insertion des paramètres additionnels

Comme précisé plus haut, les paramètres additionnels qui peuvent être inclus dans le calcul sont les données d’orientation interne, distance principale et coordonnées image du centre de perspective. On peut encore compléter la modélisation par l’insertion d’une correction (dx,dy) appliquée à la distance radiale, qui corrige les distorsions de l’optique employée. Cette correction peut s’exprimer selon différents modèles mathématiques, mais le plus souvent sous forme polynomiale.

Afin d’étudier les implications de cette insertion dans le volume de calcul, il est utile de revenir aux équations de base.

Tout d’abord, exprimons l’équation de l’orientation interne liant les paramètres cités ci-dessus.

où tau représente l’angle d’incidence d’un rayon issu d’un point de l’objet avec le rayon principal d’autocollimation (fig. 3.6).

(fig. 3.6) Modélisation d’une chambre de prise de vues (Kraus, 1998)

(fig. 3.6) Modélisation d’une chambre de prise de vues (Kraus, 1998)

RPA = Rayon Principal d’Autocollimation

PPA = Point Principal d’Autocollimation dans le plan image

PE = Pupille d’entrée, PS = Pupille de sortie

OP = centre de projection physique, OM = centre de projection mathématique

c = distance principale

D’autre part, il s’agit de choisir une modélisation mathématique des distorsions radiales. On peut par exemple utiliser un des modèles employé par le logiciel ORIENT, développé par l’Université de Graz :

Une telle modélisation fait intervenir une distance radiale caractéristique r0, valeur pour laquelle les distorsions sont alors nulles. Cette valeur est fixée arbitrairement, généralement aux 2/3 de la demi-diagonale de l’image, et permet de réduire les valeurs de correction. La distribution ainsi obtenue est communément qualifiée de balanced.

Il s’agit donc maintenant d’exprimer les corrections [12] à appliquer sur chacune des coordonnées image.

3.4.4. Conséquences de l’ajout de paramètres additionnels

Les grandes étapes du calcul général par la méthode des faisceaux étant exposées, il semble donc légitime de s’interroger sur l’effet de l’introduction des paramètres additionnels concernant données d’orientation interne et distorsions de l’objectif.

Le plus gros risque est alors de rendre le système hyperstatique. Autrement dit, le système des équations normales ne peut être résolu. C’est là le pire des cas, mais une redondance insuffisante peut également être la source de grosses imprécisions dans les résultats issus de la compensation.

Il semble donc nécessaire d’étudier la qualité à priori, et la possibilité, de la résolution du système des équations normales. Le Pr. KRAUS propose une analyse de déterminabilité (determinability analysis) basée sur l’exploitation de la diagonale de la matrice N et de son inverse (Kraus, 1997).

La relation fait intervenir la matrice unité (notée Id). Les éléments Bii de la matrice B sont des mesures de la déterminabilité des inconnues. On peut signaler deux valeurs remarquables des ces éléments :

- Bii = 0 N est une matrice diagonale

- Bii = 1 N est une matrice singulière (non-inversible)

De façon générale, on peut fixer une limite de déterminabilité du système avec la règle suivante :

Dans ce cas, la compensation ainsi réalisée est également appelée compensation par les faisceaux avec autocalibration.

4. Préparation de la mission4.1. Reconnaissance du terrain

Le tout premier contact avec la zone d’études a été cartographique. Sur la base d’une carte IGN au 1/25000, un agrandissement au 1/10000 (cf. Annexe 2) a été réalisé afin de faciliter le repérage de la bande et des différents éléments du plan de vol.

Une fois à Barcelonnette, la partie reconnaissance du terrain a consisté à repérer les zones favorables à la mise en place de points de calage matérialisés et à analyser rapidement les possibilités de déplacement. Celles-ci se sont avérées relativement limitées pour ce qui était du pourtour immédiat du glissement, mais sur la coulée elle-même, elles ont permis un arpentage assez rapide. Les dénivellations, parfois importantes, et la nature particulièrement chaotique de la zone sont les deux paramètres qui ont, par moments, posé problème lors de la stéréopréparation.

4.2. Définition des paramètres de vol

En me basant sur les travaux réalisés par Quentin GROSS (Gross, 1998), j’ai fixé l’altitude de vol à 500m au-dessus du terrain, ce qui dans l’optique de l’utilisation d’un appareil photographique classique, muni d’un objectif de 50mm, me permettait d’obtenir une échelle de 1/10000 sur les clichés.

L’appareil employé pour le vol était un avion de type CESSNA, à ailes hautes. La vitesse de croisière envisagée était de 130 km.h-1 environ, soit 35 m.s-1.

Ces paramètres de vol sont d’une importance cruciale puisque c’est à partir de ceux-ci que sont calculés le plan de vol et tous les paramètres qui le caractérisent. Il est donc très important de s’y conformer autant que possible.

4.3. Choix de la chambre de prise de vues

En fonction des objectifs à atteindre, selon les contraintes imposées par les conditions de vol et grâce au panel de chambres mis à disposition par le laboratoire de photogrammétrie de l’ENSAIS, j’ai pu faire une étude sommaire de faisabilité selon chacune de ces chambres.

Pour réaliser la couverture photographique, je disposais des chambres suivantes :

- MINOLTA, 50mm (mise à disposition par O. Maquaire)

- CANON, 50mm, avec repères de fonds de chambre

- RICOH, 28mm

- PENTAX 67, 105mm

L’appareil CANON est de type reflex, la chambre RICOH est quant à elle automatique. Ces deux appareils peuvent être qualifiés de semi-métriques, car ils font apparaître quatre marques repères, en fonds de chambre, sur l’image même. Ces deux appareils permettent de travailler avec le format classique 24x36.

Par contre, la PENTAX est une chambre métrique disposant d’un réseau de croix et qui travaille avec des films de 120mm, pour un format d’image de 50x60 mm2.

Dans l’étude qui suit, je parlerai soit de format vertical, lorsque le grand coté de la photo sera orienté perpendiculairement à l’axe de vol, soit de format horizontal (cette distinction peut s’apparenter à la façon de tenir l’appareil). Les relations utilisées pour les calculs des paramètres de couverture ont été exposées au paragraphe 3.3.3, et sont utilisées pour les paramètres de vol définis, soit 500 m d’altitude pour une vitesse de 130 km.h-1.

Les dimensions de la zone sont fixées à 1500 m de longueur pour 500 m de large.

4.3.1. Focale de 28mm

4.3.2. Focale de 50mm

4.3.3. Focale de 105mm

4.3.4. Conclusion de l’étude

Un critère décisif dans le choix de la chambre a été la présence de repères de fonds de chambre bien visibles sur le format. D’autant que dans le cadre de la réalisation d’un Photo CD KODAK, il faut tenir compte du fait que ce sont les diapositives qui sont scannées et que, par conséquent, une partie du format peut être rognée.

Compte tenu de l’échelle des clichés désirée, de la taille de l’intervalle de temps entre deux prises de vues et des contraintes de vol, l’emploi de l’appareil RICOH muni d’un objectif de 50mm s’est présenté comme la meilleure solution.

Pour ce qui est de la direction de l’axe de vol, la perpendiculaire à l’axe de la vallée a semblé s’imposer, du fait que la dénivelée entre le bas du glissement et le haut de la couronne est de l’ordre de 400m. Un vol parallèle à altitude constante aurait donné alors une différence d’échelle inacceptable entre les clichés extrêmes des bandes.

En matière de format, le choix s’est porté sur le format horizontal pour plusieurs raisons. Tout d’abord, la configuration de l’avion permettait difficilement d’assurer l’immobilité de l’appareil en format vertical. D’autre part, si on considère des prises de vues verticales, la dénivelée entre le point terrain le plus haut et le point le plus bas va avoir pour effet de changer le rapport d’échelle. La projection du format d’image au sol n’est alors pas un rectangle mais un parallélogramme, ce qui provient du fait qu’une photographie est une projection centrale (fig. 4.1). Comme les prises de vues ne pouvaient, de par les moyens mis en œuvre, être strictement verticales, cette effet aurait été accentué par l’emploi du format vertical.

(fig. 4.1) Projection centrale et différences d’altitude sur le format (Vue de dessus)

(fig. 4.1) Projection centrale et différences d’altitude sur le format (Vue de dessus)

4.4. Calibration de la chambre de prise de vues

L’emploi de l’appareil reflex RICOH, du Laboratoire de Photogrammétrie de l’ENSAIS, avec un objectif de 50mm acheté pour la mission, m’a placé dans le cas le plus défavorable à savoir une chambre semi-métrique, munie d’un objectif de qualité optique inconnue. Afin de pouvoir compter sur les meilleurs résultats possibles, il a donc été nécessaire de procéder à la calibration de ce matériel.

(fig. 4.2) Marques repères de la chambre RICOH

4.4.1. Définition et intérêt de la calibration

Lorsque l’on est amené à travailler avec une chambre de prise de vues dans le but de faire des mesures sur les clichés obtenus, il est nécessaire de procéder à une calibration. C’est, dans notre cas, d’autant plus important que l’appareil utilisé est, à la base, un appareil amateur.

Une calibration permet de déterminer les corrections à appliquer sur la distance radiale, en fonction de la distance au point principal (cf. §3.4.3), ainsi que la distance principale effective pour une mise au point donnée.

Les distorsions vont avoir pour principal effet de modifier les coordonnées images des différents points de l’image et plus particulièrement ceux qui sont situés sur les bords du format. Le nadir est peu touché par les distorsions, ce qui s’explique de par la définition de ce point d’une part, et d’autre part, se vérifie dans l’allure de la distribution des valeurs correctives (voir graphique plus bas).

Les photographies ont été réalisées avec une pellicule pour diapositives. Une fois le développement effectué, il a donc été nécessaire de scanner ces photographies afin de permettre leur traitement numérique. Ce scannage a été fait à une résolution de 1350dpi.

4.4.2. Calcul avec PHOTOMODELER

Pour calculer une calibration avec le logiciel PHOTOMODELER, la première étape est de réaliser des prises de vue d’un réseau en damier (fig. 4.3). Le logiciel impose un nombre minimum de huit clichés, pris dans des positions précisées par sa documentation.

(fig. 4.3) Réseau de calibration

On peut cependant multiplier le nombre de clichés afin d’affiner la détermination des valeurs de distorsion.

4.4.3. Calcul avec ORIENT

Pour effectuer le second calcul de calibration avec le logiciel ORIENT, développé par l’Université de Graz, j’ai réalisé une vingtaine de prises de vues sur la façade arrière de l’aile architecture de l’ENSAIS. Cette façade comporte un réseau tridimensionnel de cibles, connues en coordonnées.

Sur les clichés numérisés, et au moyen du logiciel de photogrammétrie numérique TIPHON, développé par le Laboratoire de Photogrammétrie, j’ai pu mesurer les coordonnées photo de toutes les cibles visibles sur chacun des clichés.

Un calcul en blocs par la méthode des faisceaux a permis de déterminer les corrections. De ses valeurs on obtient la courbe de distorsion de l’objectif, avec une mise au point à l’infini (les valeurs numériques des corrections de distorsions sont présentées en Annexe 2 et dans les fichiers caractéristiques de la caméra) :

4.4.4. Conclusion sur la calibration

Les distances radiales des points mesurés restent en général inférieures à 18mm, les corrections de distorsions restant alors inférieures à 40µm. On peut donc conclure que cette optique est de qualité tout à fait acceptable pour un objectif amateur.

La distance principale calibrée est légèrement différente de la focale annoncée par le constructeur, mais l’écart reste de taille prévisible. Par contre, le point principal est décalé par rapport au centre du format de façon relativement importante, la calibration fournissant les résultats suivants :

4.5. Préparation du vol photographique

4.5.1. Les points de calage

Les points de calage à matérialiser ont été réalisés dans des plaques en carton rigide. Leurs dimensions sont d’environ 45x45 cm2, soit sur les photographies au 1/10000 des marques de 45 µm.

Le sol étant relativement sombre, constitué de marnes noires mais également de rochers, ces marques repères ont été peintes en rouge et jaune. De cette façon, on est quasiment assuré qu’elles seront visibles sur les clichés, tout en veillant à les orienter toutes dans la même direction de façon à pouvoir pointer le centre sans ambiguïté, au cas où l’une des couleurs serait invisible sur un cliché.

4.5.2. Le plan de vol

Compte tenu de la définition des paramètres de vol (altitude, vitesse) et des choix en matière de focale et d’orientation du format, j’ai pu établir le plan de vol, sur la base de la carte IGN au 1/25000.

5. Opérations de terrain

5.1. Points de calage

5.1.1. Mise en place

D’après les données du plan de vol établi plus haut, il a fallu placer les marques repères de telle façon qu’elles soient visibles sur plusieurs clichés, en veillant de plus, à augmenter leur nombre sur un modèle pour amorcer le calcul d’aérotriangulation.

En fonction des contraintes du terrain, nous avons donc essayé de respecter les écartements fixés entre bandes, pour placer des balises à leurs extrémités. Cette opération s’est tout de même révélée plus ou moins hasardeuse puisqu’elle s’est faite au jugé, sans moyen de positionnement fin.

5.1.2. Levé

Les opérations de levé ont été réalisées par méthode tachéométrique, au moyen d’un théodolite WILD T1600, muni du distance-mètre DI3000. L’ensemble des observations ont été enregistrées sur module REC. Afin d’augmenter la vitesse de levé, nous avons procéder avec deux prismes. Ceci s’est avéré être un choix intéressant du fait de la taille de la zone et des difficultés de déplacement sur les pentes importantes du bassin versant.

Au cours de ce levé, nous avons stationné le pilier de centrage P2 mis en place en aval du glissement sur un promontoire rocheux. Un deuxième pilier P1 de même type est présent à proximité et a été utilisé comme point de calage pour les photographies.

Il aurait été difficile de rattacher les observations topométriques au réseau national, mais il fallait au moins pouvoir les comparer avec de précédentes campagnes d’auscultation, en tenant compte du fait que les piliers de centrage font apparaître des mouvements, dus au déplacement du glissement. En effet, le pilier P1 montre un déplacement de 1m environ, en altimétrie, par rapport aux observations de la campagne de 1997, menée par Loïc GALISSON (Galisson, 1997).

Cependant, il est important de noter que le but essentiel de cette étude est d’aboutir à une modélisation du bassin versant du glissement. Par conséquent, un quelconque rattachement au système national est tout à fait optionnel. Je me suis donc limité à exprimer les coordonnées des différents points dans le système arbitraire local, présenté plus bas.

5.2. Le vol photographique

Avec le plan et les paramètres de vol définis plus haut, il a fallu s’adapter aux conditions de vol très approximatives. En effet, l’absence de moyens de positionnement ne permettait pas un positionnement très précis. Le placement sur les différents axes de vol de chaque bande s’est donc fait à vue.

L’avion a volé sur la tranche, et légèrement de biais par rapport à sa direction de déplacement. La vitesse de 130 km.h-1 a été assez bien respectée, ce qui a pu être vérifiée sur les recouvrements longitudinaux. Le vol a été effectué vers 9h30, ce qui laissait à prévoir des ombres conséquentes en aval de la couronne.

Compte tenu des paramètres de vol et de la sensibilité du film (100 ISO), j’ai décidé de fixer la vitesse d’obturation à 1/1000, ce qui me permettait de réduire l’effet de filé. Pour cela, j’ai adapté l’ouverture de diaphragme en fonction de la luminosité du site, à l’aide du posemètre intégré dans l’appareil, à une valeur de f/5,6.